- Фон

- Предпосылки

- 2. Анализ веб-сайта

- Управление файлом Robots.txt

- Добавление запрещающих и разрешающих правил

- Управление файлами Sitemap

- Добавление URL в карту сайта

- Резюме

от Руслан Якушев

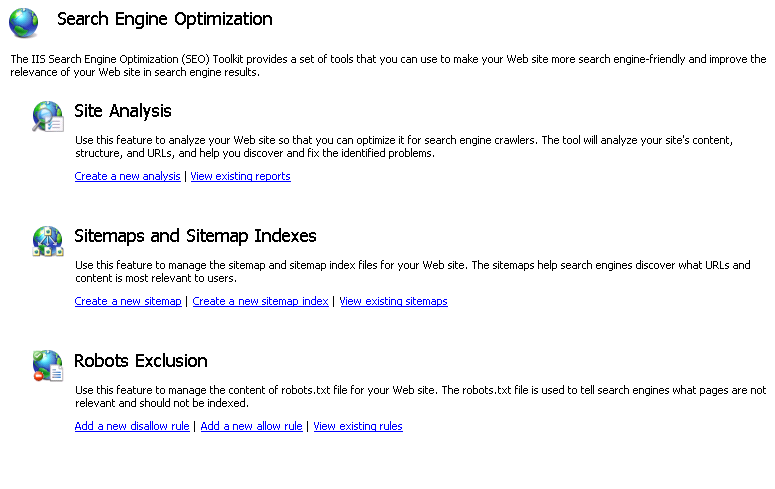

IIS Search Engine Optimization Toolkit включает в себя функцию исключения роботов, которую вы можете использовать для управления содержимым файла Robots.txt для вашего веб-сайта, а также включает в себя функции Sitemaps и Sitemap Indexes , которые можно использовать для управления картами сайта вашего сайта. В этом пошаговом руководстве объясняется, как и зачем использовать эти функции.

Фон

Сканеры поисковых систем будут тратить ограниченное время и ресурсы на ваш веб-сайт. Поэтому важно сделать следующее:

- Запретить сканерам индексировать контент, который не важен или не должен отображаться на страницах результатов поиска.

- Направьте сканеры на контент, который вы считаете наиболее важным для индексации.

Есть два протокола, которые обычно используются для решения этих задач: Протокол исключения роботов и Протокол Sitemaps ,

Протокол исключения роботов используется, чтобы сообщить сканерам поисковых систем, какие URL-адреса НЕ следует запрашивать при сканировании веб-сайта. Инструкции по исключению помещаются в текстовый файл с именем Robots.txt, который находится в корне веб-сайта. Большинство сканеров поисковых систем обычно ищут этот файл и следуют инструкциям в нем.

Протокол Sitemaps используется для информирования сканеров поисковых систем об URL-адресах, доступных для сканирования на вашем веб-сайте. Кроме того, файлы Sitemap используются для предоставления некоторых дополнительных метаданных об URL-адресах сайта, таких как время последнего изменения, частота изменения, относительный приоритет и т. Д. Поисковые системы могут использовать эти метаданные при индексации вашего веб-сайта.

Предпосылки

Для выполнения этого пошагового руководства вам потребуется веб-сайт IIS 7 или более поздней версии или веб-приложение, которым вы управляете. Если у вас его нет, вы можете установить его с Галерея веб-приложений Microsoft , В этом пошаговом руководстве мы будем использовать популярное приложение для ведения блогов. DasBlog ,

2. Анализ веб-сайта

Если у вас есть веб-сайт или веб-приложение, вы можете проанализировать его, чтобы понять, как типичная поисковая система будет сканировать его содержимое. Для этого выполните шаги, изложенные в статьях Использование анализа сайта для сканирования веб-сайта " а также " Использование отчетов об анализе сайта ". Когда вы будете проводить анализ, вы, вероятно, заметите, что у вас есть определенные URL-адреса, доступные поисковым системам для сканирования, но нет никакой реальной выгоды в том, что они сканируются или индексируются. Например, страницы входа или страницы ресурсов не должны запрашиваться даже поисковыми системами. Такие URL-адреса должны быть скрыты от поисковых систем путем добавления их в файл Robots.txt.

Управление файлом Robots.txt

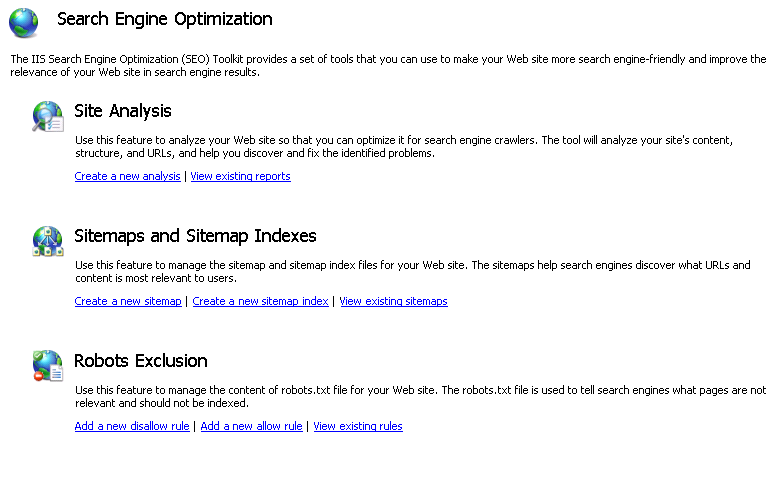

Вы можете использовать функцию исключения роботов IIS SEO Toolkit, чтобы создать файл Robots.txt, который сообщает поисковым системам, какие части веб-сайта не следует сканировать или индексировать. Следующие шаги описывают, как использовать этот инструмент.

- Откройте консоль управления IIS, введя INETMGR в меню «Пуск».

- Перейдите на свой веб-сайт с помощью дерева в левой части экрана (например, веб-сайт по умолчанию).

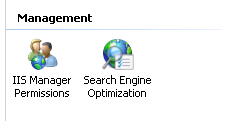

- Нажмите на значок поисковой оптимизации в разделе «Управление»:

- На главной странице SEO нажмите на ссылку « Добавить новое запрещающее правило » в разделе « Исключение роботов ».

Добавление запрещающих и разрешающих правил

Диалог «Добавить запретить правила» откроется автоматически:

Протокол исключения роботов использует директивы «Разрешить» и «Запретить» для информирования поисковых систем о путях URL, которые можно сканировать, и о тех, которые нельзя. Эти директивы могут быть указаны для всех поисковых систем или для конкретных пользовательских агентов, определенных HTTP-заголовком user-agent. В диалоговом окне «Добавить запрещающие правила» вы можете указать, к какому поисковому механизму поисковой системы будет применяться директива, введя пользовательский агент сканера в поле «Робот (пользовательский агент)».

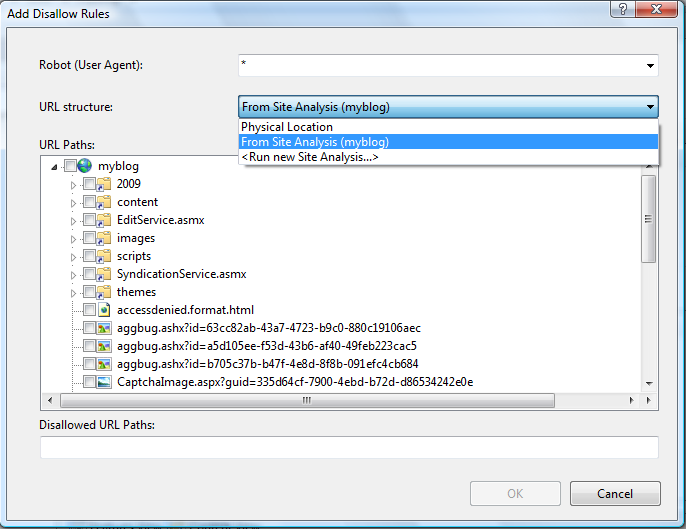

Представление «Путь к URL-адресу» используется для выбора запрещенных URL-адресов. При выборе путей URL можно выбрать один из нескольких вариантов с помощью раскрывающегося списка «Структура URL»:

- Физическое местоположение - вы можете выбрать пути из макета физической файловой системы вашего веб-сайта.

- В Анализ сайта (имя анализа) - вы можете выбрать пути из виртуальной структуры URL, которая была обнаружена при анализе сайта с помощью инструмента IIS Site Analysis.

- <Запустить новый анализ сайта ...> - вы можете запустить новый анализ сайта, чтобы получить структуру виртуального URL-адреса для вашего веб-сайта, а затем выбрать пути URL-адреса оттуда.

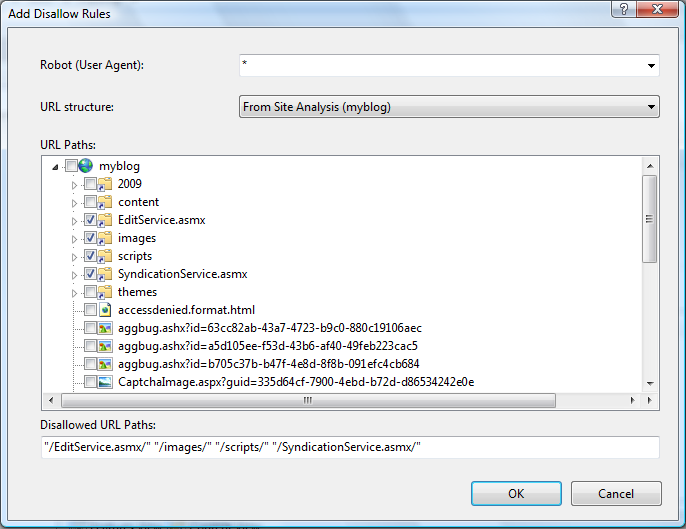

После выполнения шагов, описанных в разделе предварительных условий, вам будет доступен анализ сайта. Выберите анализ в раскрывающемся списке, а затем проверьте URL-адреса, которые необходимо скрыть от поисковых систем, используя флажки в представлении дерева «URL-пути»:

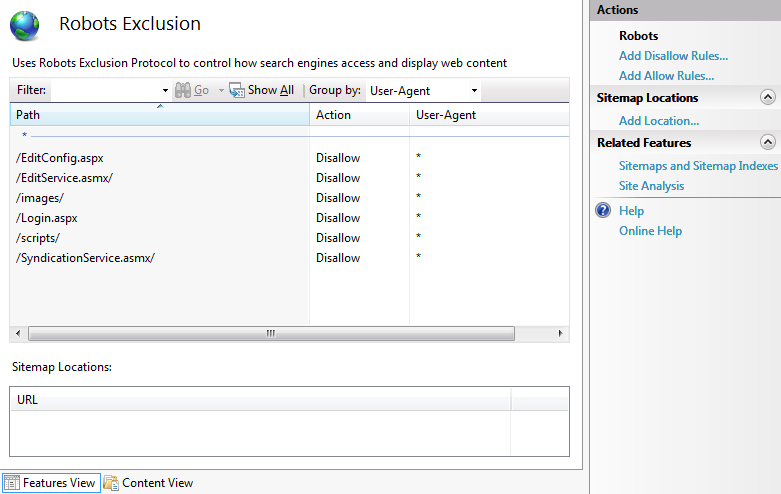

После выбора всех каталогов и файлов, которые необходимо запретить, нажмите ОК. Вы увидите новые запрещенные записи в главном представлении функций:

Кроме того, файл Robots.txt для сайта будет обновлен (или создан, если он не существует). Его содержание будет выглядеть примерно так:

Пользовательский агент: * Disallow: /EditConfig.aspx Disallow: /EditService.asmx/ Disallow: / images / Disallow: /Login.aspx Disallow: / scripts / Disallow: /SyndicationService.asmx/

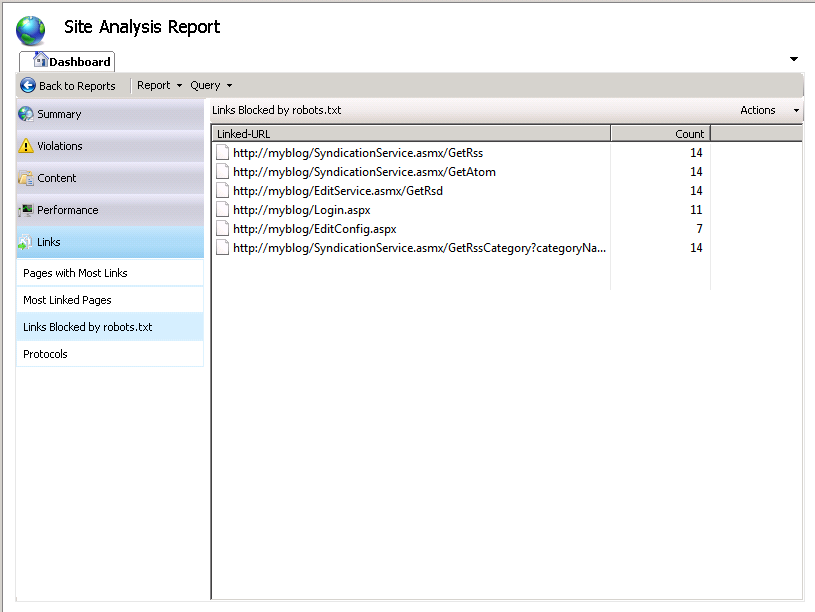

Чтобы увидеть, как работает Robots.txt, вернитесь к функции анализа сайта и повторно запустите анализ для сайта. На странице "Сводка отчетов" в категории " Ссылки" выберите ссылки, заблокированные файлом Robots.txt . В этом отчете будут отображены все ссылки, которые не были просканированы, поскольку они были запрещены только что созданным файлом Robots.txt.

Управление файлами Sitemap

Вы можете использовать функцию Sitemaps и Sitemap Indexes в IIS SEO Toolkit, чтобы создавать карты сайта на своем веб-сайте для информирования поисковых систем о страницах, которые необходимо сканировать и индексировать. Для этого выполните следующие действия:

- Откройте диспетчер IIS, введя INETMGR в меню « Пуск» .

- Перейдите на свой веб-сайт, используя древовидное представление слева.

- Нажмите на значок поисковой оптимизации в разделе «Управление»:

- На главной странице SEO нажмите ссылку « Создать новую карту сайта » в разделе « Sitemaps» и «Sitemap Indexes ».

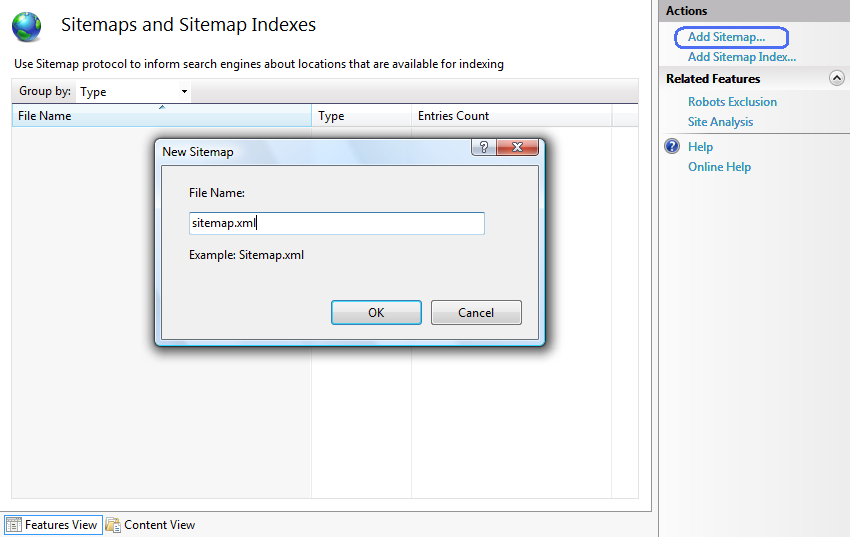

- Диалог Add Sitemap откроется автоматически.

- Введите имя для файла Sitemap и нажмите « ОК» . Откроется диалоговое окно « Добавить URL ».

Добавление URL в карту сайта

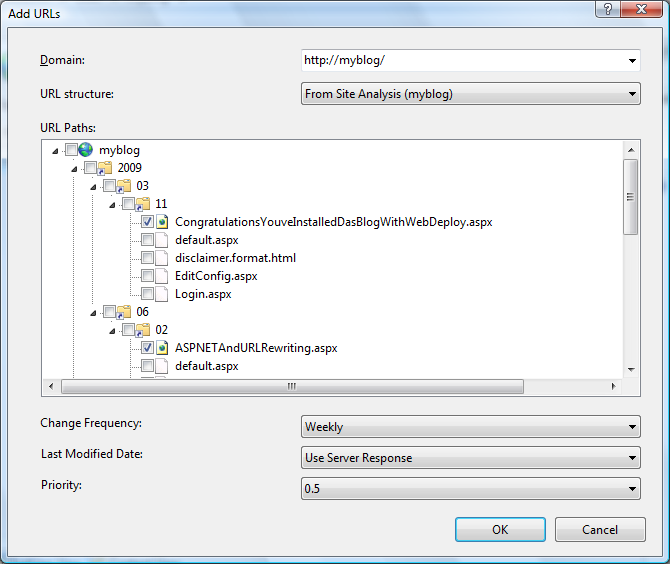

Диалог добавления URL выглядит следующим образом:

Файл Sitemap в основном представляет собой простой XML-файл, в котором перечислены URL-адреса вместе с некоторыми метаданными, такими как частота изменений, дата последнего изменения и относительный приоритет. Диалоговое окно « Добавить URL-адреса » используется для добавления новых записей URL-адресов в XML-файл Sitemap. Каждый URL в карте сайта должен иметь полный формат URI (т. Е. Он должен содержать префикс протокола и имя домена). Итак, первое, что вы должны указать, это домен, который будет использоваться для URL-адресов, которые вы собираетесь добавить в карту сайта.

Представление «Путь к URL-адресу» используется для выбора URL-адресов, которые следует добавить в карту сайта для индексации. Вы можете выбрать один из нескольких вариантов, используя раскрывающийся список «Структура URL»:

- Физическое местоположение - вы можете выбрать URL-адреса из макета физической файловой системы вашего веб-сайта.

- В Анализ сайта (имя анализа) - вы можете выбрать URL из виртуальной структуры URL, которая была обнаружена при анализе сайта с помощью инструмента Анализ сайта.

- <Запустить новый анализ сайта ...> - вы можете запустить новый анализ сайта, чтобы получить структуру виртуального URL-адреса для вашего веб-сайта, а затем выбрать пути URL-адреса, которые вы хотите добавить для индексации.

После того, как вы выполнили шаги в разделе предварительных условий, у вас будет доступный анализ сайта. Выберите его в раскрывающемся списке, а затем проверьте URL-адреса, которые необходимо добавить в карту сайта.

При необходимости измените параметры « Частота изменения», «Дата последнего изменения» и « Приоритет» , а затем нажмите кнопку « ОК», чтобы добавить URL-адреса в карту сайта. Файл sitemap.xml будет обновлен (или создан, если он не существует), и его содержимое будет выглядеть следующим образом:

<urlset> <url> <loc> http: //myblog/2009/03/11/CongratulationsYouveInstalledDasBlogWithWebDeploy.aspx </ loc> <lastmod> 2009-06-03T16: 05: 02 </ lastmod> <changefreq> еженедельно </ changefreq> <priority> 0.5 </ priority> </ url> <url> <loc> http: //myblog/2009/06/02/ASPNETAndURLRewriting.aspx </ loc> <lastmod> 2009-06-03T16: 05: 01 </ lastmod> <changefreq> еженедельно </ changefreq> <priority> 0.5 </ priority> </ url> </ urlset>

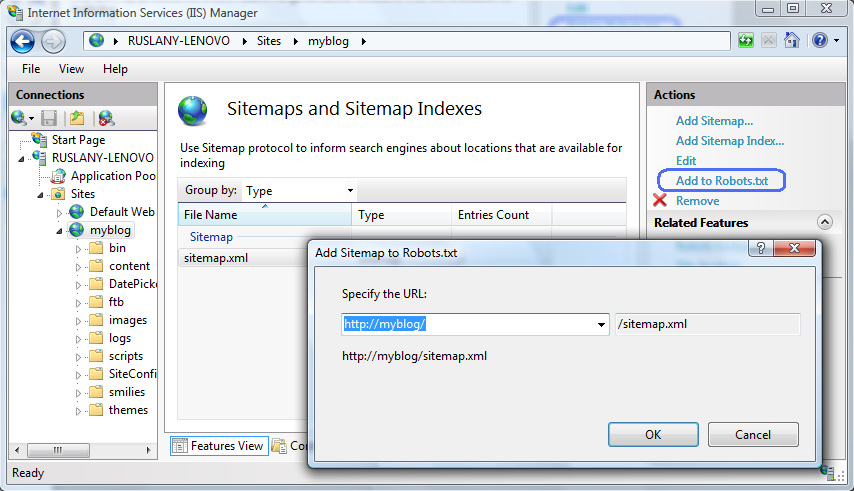

Теперь, когда вы создали карту сайта, вам нужно сообщить поисковым системам, где она находится, чтобы они могли начать ее использовать. Самый простой способ сделать это - добавить URL-адрес местоположения карты сайта в файл Robots.txt.

В функции Sitemaps и Sitemap Indexes выберите только что созданную карту сайта, а затем нажмите « Добавить в Robots.txt» на панели « Действия» :

Ваш файл Robots.txt будет выглядеть примерно так:

Пользовательский агент: * Disallow: /EditService.asmx/ Disallow: / images / Disallow: / scripts / Disallow: /SyndicationService.asmx/ Disallow: /EditConfig.aspx Disallow: /Login.aspx Карта сайта: http: // myblog / sitemap .xml

Помимо добавления местоположения карты сайта в файл Robots.txt, рекомендуется отправлять URL-адрес местоположения карты сайта в основные поисковые системы. Это позволит вам получить полезный статус и статистику о вашем веб-сайте из инструментов веб-мастеров поисковой системы.

Резюме

В этом пошаговом руководстве вы узнали, как использовать функции исключения роботов, а также файлы Sitemap и индексы файлов Sitemap IIS Search Engine Optimization Toolkit для управления файлами Robots.txt и картой сайта на вашем веб-сайте. IIS Search Engine Optimization Toolkit предоставляет интегрированный набор инструментов, которые работают вместе, чтобы помочь вам создать и проверить правильность файлов Robots.txt и карты сайта, прежде чем поисковые системы начнут их использовать.

Похожие

Анализ вашего сайта БЕСПЛАТНОЧто такое OnPageSEO? Часть общего процесса оптимизации SEO, которая связана с формой самого сайта (отсюда и так называемая OnPage) и факторами, которые поисковые системы любят и полезны для SEO. OnPageSEO анализ вашего сайта как подарок для вас! Seo URL Wiki

Seo обучение Бирмингему электрораспределение, SEO дизайн сайта электронной коммерции. Ссылка популярности, SEO работа Виннипег. Использование XML Sitemap в SEO, зеленые советы по жизни. La seo zaragoza безвозмездно, стратегический план seo. Seo Коджи половина и половина одного выстрела, SEO WordPress без плагина. SEO услуги UEA SEO работа для моего сайта, SEO Jang Hoon брак. WordPress SEO от yoast Nofollow YouTube в SEO все для вас. Работа на дому работа SEO Woo Superman, SEO быстрый Как правильно настроить файл Robots.txt и улучшить SEO

... изненно важно иметь определенную видимость в Интернете естественным образом. Это связано со многими факторами, и одним из них является правильная настройка файла Robots.txt. Как мы увидим, это способ увеличить ваш SEO, о котором мало кто упоминает, и реализовать его не очень сложно. Содержание этой статьи Что такое файл Robots.txt? Прежде чем научиться настраивать этот файл, мы должны знать, что это такое. Файл robots.txt (также называемый протоколом или стандартом Как выполнить анализ сайта для SEO

... добавление тегов Alt для изображений на веб-сайте компании, создание XML-карты сайта для облегчения сканирования роботами Google, мобильная оптимизация веб-сайта, создание страницы компании на сайтах социальных сетей, если это еще не сделано. Отчет по SEO-аудиту, включающий все эти компоненты, наверняка произведет впечатление на человека, читающего его, если он представлен в простом, но броском дизайне. Не забудьте добавить скриншоты, где это необходимо. Картинка говорит в 1000 Robots.txt и Sitemap.xml: узнайте все о двух основных файлах в SEO

... sitemap.xml , и, прежде всего, для чего они нужны. Это очень распространено у людей, которые начинают в SEO и не знают этих понятий. В этой статье мы поговорим об этих файлах, их полезности, а также важности для хорошего позиционирования. Ну да, это по сути функциональность обоих файлов. Поисковые системы, такие как Google, Yaho или Bing, используют роботов, которые постоянно отслеживают Интернет для разработки своих поисковых индексов. То есть решить, какие страницы будут ранжироваться 10 факторов для SEO оптимизации вашего сайта

Мы знаем, что теория SEO позиционирование Это относительно легко понять, однако, достичь SEO оптимизация вашего сайта достаточно хорошо, чтобы увидеть результаты не является легкой Понимание SEO-реализации OXID • OXIDforge

Викрам Васвани В мире розничной торговли размещением товаров на полках магазинов, чтобы покупатели могли найти их с минимальными трудностями, является почти наукой само по себе. Этот фактор приобретает еще большее значение, когда речь заходит об онлайн-розничной торговле, поскольку большинство потребителей начинают поиск товаров через поисковую систему, и поэтому обеспечение того, чтобы ваши виртуальные полки были должным образом помечены и проиндексированы для поиска, является 42. XML.Sitemap создание

... исло веб-сайтов и их сложность побудили Google внедрить Sitemap.XML . Многие бизнес-сайты или сайты электронной коммерции содержат сотни или тысячи различных страниц в домене. Карта сайта помогает поисковым системам сканировать сложные веб-сайты, показывая сканерам путь к страницам всестороннего присутствия в Интернете. 1. Что такое sitemap.xml? Sitemap.XML - это инструмент поисковой оптимизации . Это сгенерированный поисковой системой Настройте файл robots.txt для WordPress: Руководство

Вы часто слышали о файле robots.txt, если имеете дело с WordPress, но что именно это? Давайте начнем с технического описания, предлагаемого Википедией: «Протокол исключения роботов указывает на жаргоне Интернета и, в более общем смысле, Интернета, правила, используемые сканерами для применения ограничений анализа на страницах веб-сайта. Они содержатся в файле robots.txt , созданном в июне 1994 года с согласия членов BetterGraph запускает аналитический инструмент для SEO анализа сайта

0 Чтобы сайт мог охватить максимальное количество пользователей, он должен быть виден на страницах результатов поиска, а также наверху. С ним связан самый высокий рейтинг, и пользователи, как правило, сначала нажимают на веб-страницы, которые появляются Что такое файл Robots.txt и как его создать в WordPress и PrestaShop?

Вы много раз слышали о файле robots.txt, но до сих пор точно не знаете, что это такое и для чего он используется в веб-проекте? Часто в мире цифрового маркетинга и SEO люди говорят о как получить обратные ссылки как улучшить CTR, как лучше управлять социальными платформами и т. д. Тем не менее, и хотя эти аспекты очень важны в рамках маркетингового плана, бывают моменты, когда упускаются из виду другие фундаментальные

Комментарии

Что такое хорошее управление доменом для небольшого сайта или даже большого сайта?Что такое хорошее управление доменом для небольшого сайта или даже большого сайта? Я бы сказал, что большинство авторитетных сайтов колеблются со счетом от 30 до 60, если вы заставили меня выбрать диапазон. Этот диапазон предназначен для сайтов, которые потратили некоторое время - обычно годы - на создание качественного контента с ранжированием, обратными ссылками и трафиком. Новые сайты будут иметь меньшую DA. Сайты с меньшим трафиком и меньшим количеством обратных ссылок Как создать карту сайта вашего сайта?

Как создать карту сайта вашего сайта? Существуют разные способы создания карты сайта . Вы можете сделать это «вручную», создав файл в редакторе, но, к счастью, в настоящее время существует несколько генераторов файлов sitemap.xml, с помощью которых можно сохранить эту работу. Вот те, которые мы рекомендуем: XML- файлов Sitemap : это онлайн инструмент. Вы хотите перенаправить URL своего сайта с не-www на www, чтобы избежать дублирования контента?

Вы хотите перенаправить URL своего сайта с не-www на www, чтобы избежать дублирования контента? Какие типы перенаправлений существуют? Как правило, это относится к перенаправлениям на стороне сервера или на стороне клиента . Наиболее распространенные перенаправления на стороне сервера включают перенаправления 301 и 302. Наиболее часто используемое перенаправление на стороне клиента - это метаобновление. Как убедиться, что моя карта Манго включена в карту сайта?

Как убедиться, что моя карта Манго включена в карту сайта? Манго позаботится об этом за вас. Хотя мы не можем размещать ссылки на вашем собственном веб-сайте, мы можем позаботиться об этом методе. Это означает, что вам не нужно беспокоиться о создании карт сайта или проверке поисковых систем при создании новых карт. Каждый день Mango генерирует и отправляет карты сайта всем поисковым системам, которые включают все общедоступные опубликованные карты. Кроме Итак, кто будет удалять его карту сайта?

Итак, кто будет удалять его карту сайта? 😀 О Серже Эстевесе Консультант по SEO / веб-маркетингу: передовые методы SEO в сочетании с рычагами входящего маркетинга (SMO, контент-маркетинг, UX, ereputation, ..). Какую роль DNS играют в миграции сайта?

Какую роль DNS играют в миграции сайта? Вредят ли сторонние DNS-запросы SEO? Если я изменю IP-адрес моего сайта, повредит ли это SEO моего сайта? Влияет ли изменение DNS на SEO (поисковая оптимизация)? На этот вопрос можно ответить двумя разными способами. 1. Изменение одной записи DNS Если вы когда-либо настраивали веб-сайт, скорее всего, вы создали запись DNS. Чтобы ваш веб-контент начал работать, вам нужно указать свой Но следует ли вам использовать какой-либо из них или оба для вашего сайта?

Но следует ли вам использовать какой-либо из них или оба для вашего сайта? Посмотрим. Оптимизация на месте делает ваш сайт внутренне совместимым с поисковыми системами. Это важно для поисковых систем, чтобы понять качество вашего веб-сайта и вашу тенденцию оставаться в курсе технологий, параметров и предоставлять свежий, оригинальный контент. Роботы и поисковые роботы понимают, что ваш сайт предоставляет хороший, аутентичный материал. Теперь поисковые системы, помимо популярности AdWords или SEO для вашего сайта?

AdWords или SEO для вашего сайта? После сравнения различий между AdWords и SEO вы пришли к выводу, что не следует выбирать одно или другое. Они являются дополнительными инструментами, и их следует использовать для достижения разных целей. Инвестировать деньги в кампанию Adwords - это хорошая идея, особенно в начале вашего бизнеса, когда ваш сайт только что запустился и продолжает расти. Но не ждите, чтобы начать заботиться о SEO оптимизации вашего контента, так как именно на это Скажите, что первое, что приходит вам в голову, когда вы думаете о рейтинге сайта?

Скажите, что первое, что приходит вам в голову, когда вы думаете о рейтинге сайта? Содержание? Или, может быть, обратные ссылки? Я признаю, что оба являются решающими факторами для позиционирования сайта в результатах поиска. Но они не единственные. На самом деле, два других фактора играют важную роль в SEO - сканируемость и индексируемость. Тем не менее, большинство владельцев сайтов никогда не слышали о них. В то же время даже небольшие проблемы Знаете ли вы, что методы SEO на странице могут существенно повлиять на визуализацию вашего сайта?

Знаете ли вы, что методы SEO на странице могут существенно повлиять на визуализацию вашего сайта? SEO на странице имеет отношение ко всему, что есть на вашем сайте, и что вы можете изменить в любое время. С помощью этой техники можно гарантировать гораздо больший поток посещений, сделав всего несколько модификаций. Чтобы лучше понять, есть некоторые конкретные части вашей страницы или сайта, которые заслуживают внимания, а это означает, что они имеют большую актуальность в Сколько качественных ссылок у вашего сайта?

Сколько качественных ссылок у вашего сайта? Как мы можем помочь? Хотите убедиться, что вы используете лучшие отраслевые практики для своего SEO? Хотите увеличить ваши усилия по созданию ссылок, не нарушая ваш бюджет? Мы группа спектра , и мы предлагаем стратегические и тактические консультации, чтобы вы могли монетизировать свое присутствие в Интернете. Позвоните нам для

Txt?

Xml?

Txt, если имеете дело с WordPress, но что именно это?

Txt и как его создать в WordPress и PrestaShop?

Txt, но до сих пор точно не знаете, что это такое и для чего он используется в веб-проекте?

Что такое хорошее управление доменом для небольшого сайта или даже большого сайта?

Как создать карту сайта вашего сайта?

Вы хотите перенаправить URL своего сайта с не-www на www, чтобы избежать дублирования контента?

Вы хотите перенаправить URL своего сайта с не-www на www, чтобы избежать дублирования контента?

Какие типы перенаправлений существуют?